Im 21. Jahrhundert hat die KI (Künstliche Intelligenz) Aufgaben wie das einfache Besiegen von Menschen beim Schach oder das schnelle Unterrichten von Fremdsprachen erfüllt.

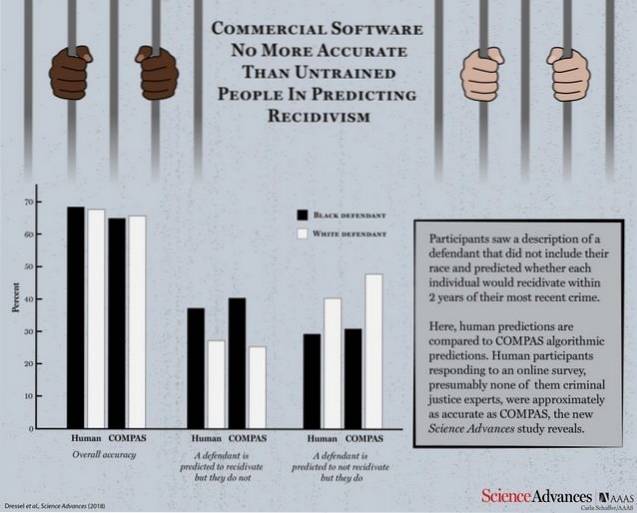

Eine fortgeschrittenere Aufgabe für den Computer wäre die Vorhersage der Wahrscheinlichkeit eines Täters, ein anderes Verbrechen zu begehen. Dies ist die Aufgabe eines KI-Systems namens COMPAS (Correctional Offender Management Profiling für alternative Sanktionen). Aber es stellt sich heraus, dass das Tool nicht besser als ein durchschnittlicher Kerl ist und auch rassistisch sein kann. Genau das hat ein Forschungsteam herausgefunden, nachdem es das KI-System, das von Justizbehörden weit verbreitet ist, eingehend untersucht hat.

Laut einem von Science Advances veröffentlichten Forschungsbericht wurde COMPAS gegen eine Gruppe menschlicher Teilnehmer ausgespielt, um seine Effizienz zu testen und zu überprüfen, wie gut es gegen die logischen Vorhersagen einer normalen Person abschneidet. Der Maschine und den menschlichen Teilnehmern wurden 1000 Testbeschreibungen zur Verfügung gestellt, die Alter, frühere Straftaten, Geschlecht usw. von Straftätern enthielten, deren Wahrscheinlichkeit von wiederholten Straftaten vorhergesagt werden sollte.

Mit erheblich weniger Informationen als COMPAS (nur 7 Funktionen im Vergleich zu COMPAS 137) ist eine kleine Menge von Nichtfachleuten genauso genau wie COMPAS bei der Vorhersage von Rückfällen.

COMPAS erzielte eine Gesamtgenauigkeit von 65,4% bei der Vorhersage von Rückfällen (die Tendenz eines verurteilten Verbrechers, erneut zu beleidigen), was weniger ist als die kollektive Vorhersagegenauigkeit menschlicher Teilnehmer von 67%..

Nehmen Sie sich jetzt einen Moment Zeit und denken Sie daran, dass das KI-System, das nicht besser abschneidet als eine durchschnittliche Person, von Gerichten verwendet wurde, um Rückfälle vorherzusagen.

Kommerzielle Software, die häufig zur Vorhersage von Rückfällen verwendet wird, ist nicht genauer oder fairer als die Vorhersagen von Personen mit wenig bis gar keiner Erfahrung in der Strafjustiz, die auf eine Online-Umfrage geantwortet haben.

Was noch schlimmer ist, ist die Tatsache, dass das System genauso anfällig für rassistische Vorurteile war wie seine menschlichen Kollegen, als sie gebeten wurden, die Wahrscheinlichkeit eines Rückfalls anhand von Beschreibungen vorherzusagen, die auch rassistische Informationen der Täter enthielten. Sie sollten dort nicht zu überrascht sein, da die KI bekanntermaßen die Muster annimmt, die ihre menschlichen Lehrer programmieren, um sie zu lernen.

Obwohl beide Seiten einen akzeptablen Genauigkeitswert drastisch verfehlen, wirft die Verwendung eines KI-Werkzeugs, das nicht besser als ein durchschnittlicher Mensch ist, viele Fragen auf.

Gadgetshowto

Gadgetshowto