Google Maps ist offensichtlich die beliebteste Karten- und Navigations-App, nicht nur für Android, sondern auch für iOS. Es ist die Go-to-App, um Wegbeschreibungen abzurufen und nach Benzinpumpen, Restaurants oder Krankenhäusern in der Nähe zu suchen. Ein Twitter-Nutzer ist jedoch auf eine abfällige Suchanfrage gestoßen, die den Suchalgorithmus von Google in Frage stellt, insbesondere weil dadurch kleine Kinder verwundbar werden.

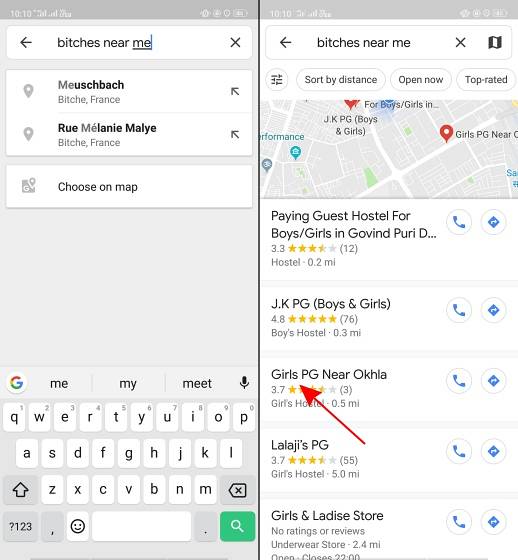

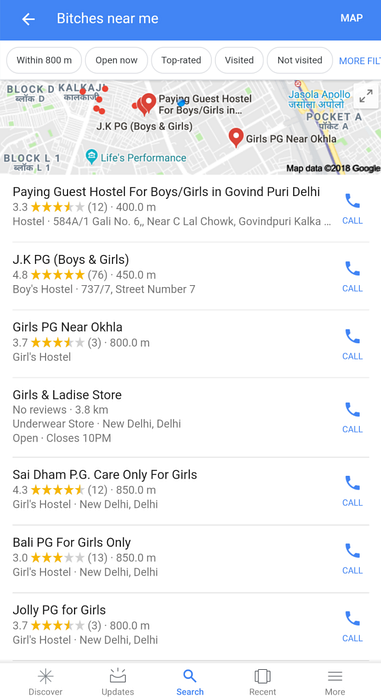

Wie der Twitter-Nutzer @AHappyChipmunk berichtet, ist das Suchergebnis schrecklich, wenn Sie Google Maps öffnen und nach "Hündinnen in meiner Nähe" suchen. Die Plattform greift diesen abfälligen Slang (den wir verurteilen) auf und zeigt Mädchenschulen, Colleges, Herbergen und zahlende Gästewohnungen, sodass Sie nur eine Sekunde innehalten. In einem Land wie Indien, in dem das abfällige N-Wort von unwissenden Teilen der Bevölkerung verwendet wird, um anzugeben, sind Suchbegriffe wie Hündinnen nicht schwer vorstellbar.

Google, kannst du erklären, warum dieses Fuckin existiert pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25. November 2018

Dieser Tweet ist eine schreckliche Überraschung, aber als ich das Logo eines Twitter-Kontos eines Trolls (@trollenku) sah, war ich skeptisch gegenüber dem obigen Tweet, und ich dachte zunächst, es sei ein Witz. Erst als wir dieselbe Suchanfrage selbst verwendeten, stellten wir fest, dass es sich nicht nur um Schulen handelt. Der Google-Algorithmus gibt jeden Ort in Ihrer Nähe zurück, der mit Mädchen in Verbindung steht - einschließlich Vermietungen nur für Mädchen und anderer Herbergen.

Gleiches gilt für die Google-Suche nach diesem Ausdruck:

Man muss verstehen, dass niemand in Google dafür verantwortlich ist. Googles Algorithmus scheint Hündinnen mit Mädchen zu korrelieren, was die Tendenz der KI erneut in Frage stellt. Schließlich lernt eine Maschine nur, was Sie ihr beibringen.

Das Das Suchergebnis zeigt die dunkle Seite der KI und wie Popkultur Sie dazu bringen kann, bestimmte Begriffe einem bestimmten Geschlecht zuzuordnen. Es wird auch hervorgehoben, wie die Personen denken, die diese Suchalgorithmen erstellen. Google sollte nach dem Streik der Massenmitarbeiter im Zusammenhang mit sexueller Belästigung in seinen Büros Anfang dieses Monats besonders vorsichtig sein. Die angebliche "Bro-Kultur" bei Google hat ihm auch ein oder zwei Klagen eingebracht. Und diese neueste KI-Gaffe kommt zu einer Zeit, in der die Sichtbarkeit dank der # MeToo-Bewegung in Indien verbessert wird.

Viele Leute haben bei Google getwittert, um weitere Informationen zu diesem Algorithmus zu erhalten. Wir werden Ihnen das Update bringen, sobald wir eine Antwort vom Unternehmen erhalten.

Gadgetshowto

Gadgetshowto